2258 > 4671

Si queremos fortalecer nuestra presencia profesional en línea, LinkedIn es una de las mejores plataformas para hacerlo. No solo es una red social para conectar con otros profesionales, sino que también nos permite mostrar nuestra experiencia, compartir contenido y generar oportunidades de negocio. Pero, ¿cómo podemos aprovechar todo esto en nuestro sitio de WordPress?

La respuesta está en los plugins de LinkedIn para WordPress. Estas herramientas facilitan la integración de LinkedIn en nuestro sitio web WordPress, permitiendo mostrar perfiles, compartir contenido de forma automática, agregar botones de seguimiento y aceptar solicitudes de empleo.

Si tenemos un blog en WordPress, una tienda en línea o un sitio corporativo, contar con un plugin de LinkedIn puede ayudarnos a atraer más visitantes, generar confianza y facilitar la interacción con nuestra audiencia. Lo mejor es que hay opciones para diferentes necesidades, desde plugins que añaden un simple botón de compartir hasta herramientas más avanzadas que permiten el inicio de sesión con LinkedIn o la publicación automática de nuestros artículos en esta red.

En esta guía, exploraremos los mejores plugins de LinkedIn para WordPress, sus características y cómo pueden ayudarnos a aprovechar al máximo esta integración. Si queremos llevar nuestra presencia en LinkedIn al siguiente nivel, aquí encontraremos las herramientas perfectas para lograrlo.

¡Empecemos!

Cómo crear el archivo robots.txt en WordPress

Cómo optimizar el Robots de WordPress

Comodines a utilizar en robots.txt

Al configurar el archivo robots.txt en WordPress, algunos caracteres especiales pueden marcar la diferencia entre una configuración efectiva y el bloqueo accidental de contenido importante. Estos comodines permiten definir reglas más dinámicas, optimizando cómo los motores de búsqueda acceden a nuestro sitio web. Vamos a repasarlos de manera sencilla para que podamos usarlos con confianza.

Almohadilla (#) – Para añadir comentarios

Uno de los elementos más simples, pero útiles dentro del robots.txt WordPress es la almohadilla (#). Aunque no afecta cómo los motores de búsqueda rastrean nuestro sitio, su función es crucial para mantener el archivo organizado y comprensible. Al usar varias reglas en robots.txt, los comentarios ayudan a recordar el motivo de las restricciones y facilitan su comprensión para otros administradores.

Por ejemplo, si hemos bloqueado una carpeta en particular, podemos añadir una nota explicativa:

# Bloqueo del directorio de administración

Disallow: /wp-admin/

Lo que obtendremos con esto es que el Googlebot va a ignorar la línea con # y solo aplicará la directiva Disallow.

Asterisco (*) – Representa cualquier secuencia de caracteres

El asterisco (*) es uno de los comodines más versátiles en robots.txt WordPress porque nos permite crear reglas generales sin necesidad de especificar cada URL de manera individual.

Funciona como un comodín universal que representa cualquier conjunto de caracteres dentro de una URL. Esto es en especial útil cuando queremos bloquear o permitir páginas con patrones similares sin escribir cada una de forma manual.

Por ejemplo, si queremos evitar que Google rastree cualquier archivo en formato PDF en WordPress o los que sigan a una referencia sin importar en qué parte del sitio se encuentre, podemos usar la siguiente regla:

Disallow: /*.pdf

Disallow: /*?ref=

Símbolo de dólar ($) – Indica el final de una URL

A veces, no solo queremos bloquear ciertas páginas o archivos en nuestro robots.txt WordPress, sino asegurarnos de que la regla solo se aplique a URL que terminen de una manera específica. Aquí es donde entra en juego el símbolo de dólar ($), que indica el final exacto de una URL.

Supongamos que queremos bloquear solo las imágenes en formato JPG sin afectar otras páginas o recursos que contengan jpg en su estructura. En este caso, usaríamos la siguiente regla:

Disallow: /*.jpg$

Con esta configuración, todas las URLs que terminen en .jpg serán bloqueadas, pero si una imagen forma parte de una URL más larga con parámetros adicionales, como imagen.jpg?size=large, esta regla no la afectará.

Es un detalle importante cuando queremos ser precisos en la configuración de nuestro archivo robots.txt WordPress y asegurarnos de que solo las páginas o archivos específicos sean restringidos para los motores de búsqueda.

User-agent – Aplicando reglas a bots específicos

El comando User-agent es fundamental dentro de robots.txt, ya que nos permite aplicar reglas a rastreadores específicos o a todos los motores de búsqueda en general. Esto es útil cuando queremos diferenciar cómo distintos bots interactúan con nuestro sitio.

Si queremos que todas las reglas dentro del archivo se apliquen a cualquier motor de búsqueda, utilizamos User-agent: *:

User-agent: *

Disallow: /privado/

Con esto, todos los bots respetarán la restricción de acceso a /privado/. Pero si, por ejemplo, queremos que solo Googlebot evite una sección específica mientras otros rastreadores sí pueden acceder, podemos personalizar la regla así:

User-agent: Googlebot

Disallow: /test/

Esto bloqueará a Googlebot en /test/, pero otros motores de búsqueda, como Bingbot, podrán seguir accediendo. Esta flexibilidad nos permite controlar qué partes de nuestro sitio queremos ocultar a ciertos motores de búsqueda sin afectar a todos por igual.

Allow y Disallow – Definiendo accesos en robots.txt

Dentro de nuestro robots.txt WordPress, dos de las directivas más importantes son Disallow y Allow. Mientras que Disallow impide que los bots accedan a ciertas rutas, Allow hace excepciones dentro de directorios bloqueados. Esta combinación es clave cuando queremos restringir una carpeta completa pero permitir el acceso a ciertos archivos dentro de ella.

Un caso común en WordPress es bloquear el acceso a wp-admin, pero permitir que ciertos archivos sigan siendo accesibles para garantizar el correcto funcionamiento del sitio:

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

¿Qué ocurre con el Linkjuice en un Disallow?

Noindex y nofollow

Antes, se podía utilizar Noindex dentro del robots.txt WordPress para indicar a los motores de búsqueda que no indexaran ciertas páginas. Sin embargo, desde 2019, Google dejó de soportar esta directiva en robots.txt. Si aún tenemos reglas de este tipo en nuestro archivo, es recomendable eliminarlas y buscar alternativas más efectivas para evitar la indexación de contenido no deseado.

La mejor opción hoy en día es utilizar meta robots en cada página específica o configurar reglas a nivel de servidor mediante el archivo .htaccess. De esta manera, garantizamos que las páginas que no queremos indexar no sean mostradas en los resultados de búsqueda.

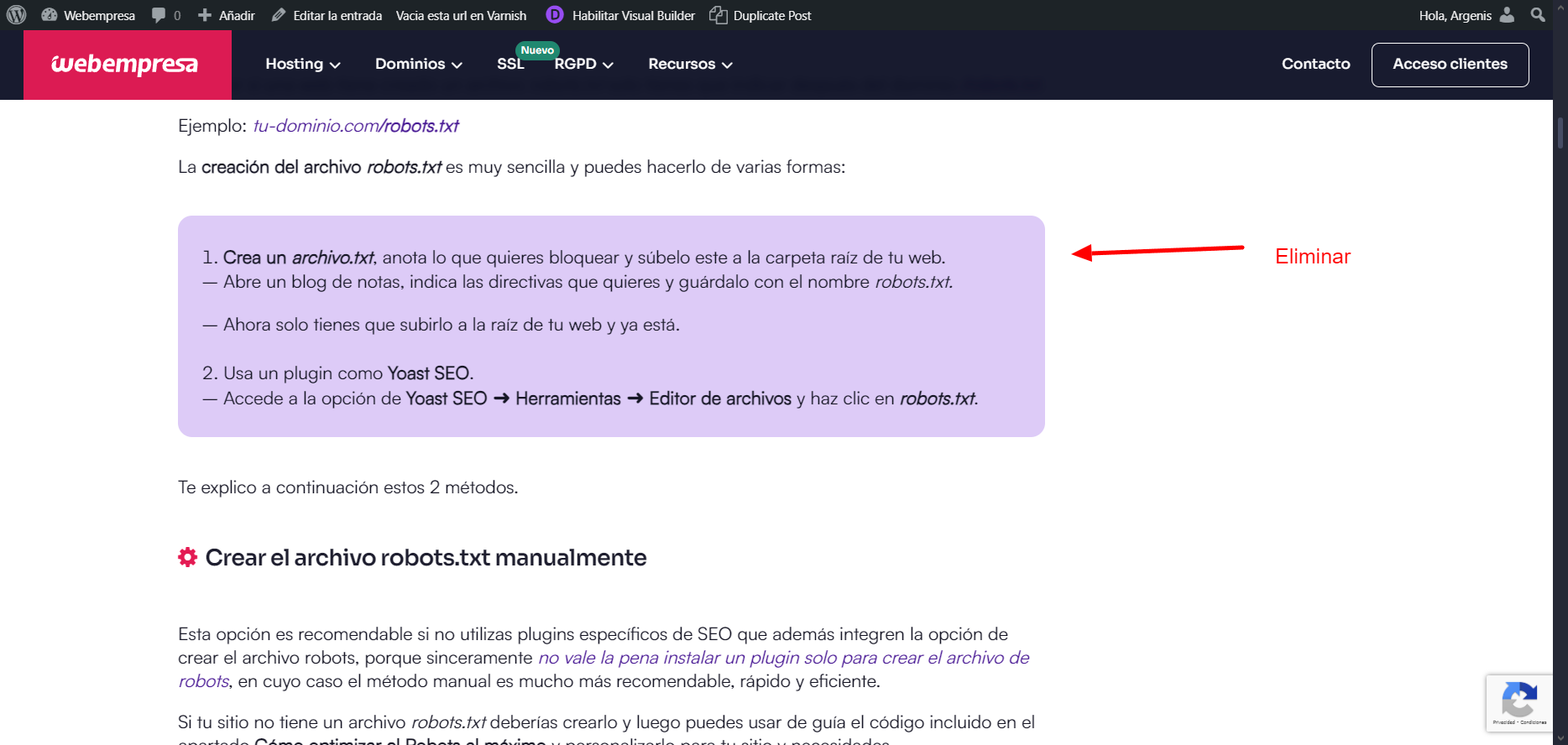

Crear el archivo robots.txt manualmente

Si no usas plugins de SEO que incluyan la opción de crear el archivo robots, es mejor hacerlo de forma manual, ya que es más rápido, eficiente y no requiere instalar un plugin solo para esta tarea.

Si tu sitio no tiene un archivo robots.txt deberías crearlo y luego puedes usar de guía el código incluido en el apartado Cómo optimizar el Robots al máximo y personalizarlo para tu sitio y necesidades.

CAMBIAR TODOS LOS MENTES